UMJETNA INTELIGENCIJA

Je li superinteligencija neizbježna i treba li je se bojati? Tri scenarija

Vladimir Lokner / 6. veljače 2026. / Perspektive Rasprave / čita se 14 minuta

Vladimir Lokner / 6. veljače 2026. / Perspektive Rasprave / čita se 14 minuta

Vladimir Lokner / 6. veljače 2026. / Perspektive Rasprave / čita se 14 minuta

Vladimir Lokner / 6. veljače 2026. / Perspektive Rasprave / čita se 14 minuta

Zbog svega što može poći po zlu u razvoju superinteligencije, skepsa nije pretjerivanje, piše Vladimir Lokner razmatrajući moguće scenarije. Utopijski scenarij u kojem je UI podređena ljudskom i planetarnom opstanku nažalost je najmanje izgledan, dok su druga dva scenarija puno izgledniji i puno manje poželjni. Razvoj UI koncentriran je u rukama velikih korporacija, vojno-industrijskih struktura i geopolitičkih aktera, a njihovi su motivi dominacija i profit.

„Pismo će uništiti pamćenje i mudrost“, kaže Sokrat u u Platonovu dijalogu Fedar, negdje u 4. st. pr. Kr. Platon vrdi da će pisanje oslabiti pamćenje, stvoriti privid znanja bez stvarnog razumijevanja i proizvesti „ljude koji mnogo znaju, ali malo razumiju“. Platona je brinula budućnost u kojoj se tehnika pisanja i čitanja širi. Znao je da dolazi promjena i u tome je slutio opasnost. Danas je to gotovo komično. Bez pisma ne bi postojala civilizacija kakvu poznajemo; uostalom, ne bismo znali ni za Platonovo djelo.

Mnogo se puta tijekom povijesti ponovio strah od promjena koje nose nove tehnologije. Na primjer, u 19. stoljeću liječnici su upozoravali da brzine iznad 30 km na sat oštećuju mozak, da putnici neće moći disati te da će žene dobiti „histeriju“; ukratko, vlakovi će uzrokovati ludilo i gušenje. Slični su strahovi bili česti u posljednjih stotinjak godina: telefon će uništiti osobne odnose; radio i televizija hipnotiziraju mase; računala će učiniti ljude glupljima; videoigre će stvoriti nasilne sociopate; internet je kraj istine i društva. Ti strahovi još traju i ponavljaju se često – iako glavninom nisu opravdani – ne zato što su ljudi glupi, nego zato što govoreći o neizvjesnoj budućnosti projiciraju najgore moguće ishode, a zanemaruju ljudsku prilagodljivost i podcjenjuju institucionalni razvoj. Strah je razumljiv, iako stvarnost demantira projekcije distopijske budućnosti.

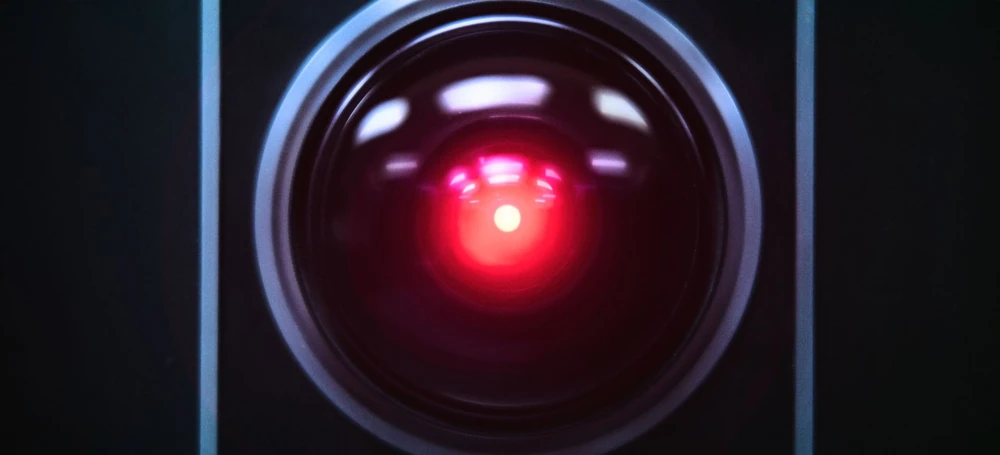

Živimo u vremenu kad svakome dostupna umjetna inteligencija (UI) izgleda čudesno, jer obavlja prije desetak godina nezamislivom brzinom i temeljitošću poslove za koje se mislilo da ih samo ljudi – dapače, samo pametni ljudi – mogu obavljati. UI napreduje i nastavit će napredovati u narednim godinama. Razvojni put koji se danas nazire vodi od uske UI – sustava iznimno učinkovitih u pojedinim zadacima, preko opće UI – približno jednake ljudskoj općoj inteligenciji, prema superinteligenciji koja bi u gotovo svim kognitivnim domenama široko nadmašila čovjeka.

Koliko smo daleko od superinteligencije? Procjene se razlikuju ovisno o školama mišljenja. Svaka od njih ima vlastite metode i implicitne pretpostavke o ljudima, o tehnologiji i o društvu. No, sve su procjene ekstrapolacije i zato ih treba uzeti cum grano salis. Govori se o tri škole. U prvoj su tehnološki futuristi, istraživači UI industrije – i izravno zainteresirani: milijarderi i milijunaši koji ovoga časa ulažu silan novac u UI, s nadom da će im se uloženo vratiti uz do sada neviđene profite. Ta vrlo optimistična grupacija očekuje superinteligenciju već za deset do 20 godina, dakle odmah iza 2040.

U drugoj su većinom akademski istraživači i filozofi tehnologije koji, isto tako, ne dvoje o tome hoće li superinteligencije biti. Ali, oni, opreznije, pojavu superinteligencije vide kasnije, u drugoj polovici ovog stoljeća, za 30 do 70 godina.

U trećoj su školi skeptici koji superinteligenciju vide još kasnije, za stotinjak godina ili čak – nikada. Tipični zagovornici ove procjene su kognitivni znanstvenici i neki neuroznanstvenici koji govore da uopće ne razumijemo ljudsku svijest, da inteligencija nije algoritamski problem, jer, u stvari, ne znamo što je točno inteligencija.

Dakle, upućeni, oni koji rade na ostvarenju superinteligencije i oni koji o njoj razmišljaju smatraju da će se barem obrisi funkcionalne superinteligencije vidjeti već ovoga stoljeća.

Isto tako, većina relevantnih istraživača slaže se da bi superinteligencija mogla biti golemi tehnološki korak naprijed – veći nego bilo koji do sada – jer bi ljudi uz njezinu pomoć bili sposobni riješiti – uz neke uvjete – većinu današnjih problema: optimizirati globalne energetske sustave, ubrzati proizvodnju čiste energije do razine obilja, smanjiti rasipanje resursa u proizvodnji i logistici, preventivnom medicinom prijeći od liječenja bolesti na održavanje zdravlja, osigurati ljudima više slobodnog vremena bez egzistencijalnog straha te stabilizirati Zemlju i njezine ekosustave.

Oni koji maštaju navode i mnoga druga čudesa. Osim optimizma i nade u blistavu budućnost većina onih koji vide i žele superinteligenciju, kao i uvijek kod svakog tehnološkog skoka, ne skrivaju skepsu, a često pokazuju i (tradicionalni) strah od onoga što nas čeka. Ponovno se javlja tehnološka tjeskoba na rubu panike. Sve se brzo razvija i svi se pitaju jesmo li mi za takav korak spremni? I, uostalom, kamo će nas taj korak dovesti? Društvo će koristiti moćne alate, ali još nitko ne razumije kakve će biti dugoročne posljedice radikalnih tehnoloških promjena. Svima je jasno da i ovaj put tehnologija napreduje brže od etike, prava i kolektivne mudrosti. Moralna arhitektura homo sapiensa nikada nije evoluirala brzinom tehnologije pa je oprez na rubu straha opravdan.

Stoga, ovoga časa ključno pitanje nije „kada“, nego „u kakvom kontekstu“ će superinteligencija nastati. Bez obzira koliko će taj put trajati on će se zbivati u današnjem zbrkanom svijetu geopolitičkog rivalstva, političkih i ekonomskih prestrojavanja u kojem su pravila i dogovori sve manje važni, u svijetu teške ekološke krize, koju dobar dio ljudi koji vodi politiku ignorira, i u svijetu ekstremnih nejednakosti sa superbogatima koji će – za vjerovati je – u vlastitom interesu, a to znači u interesu profita i stvaranja moći, trasirati put razvitka UI. Problem nastanka i funkcioniranja superinteligencije nije primarno tehnički, nego antropološki i politički; važnije od toga što će sve UI moći je tko su ljudi koji je stvaraju i u čijem interesu.

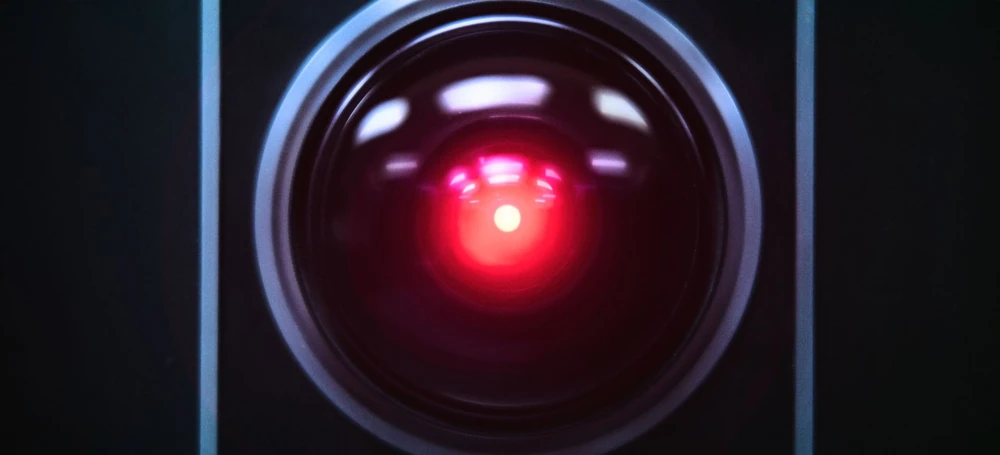

K tome, u futurističkoj i transhumanističkoj literaturi – osobito kod autora poput Nicka Bostroma ili Yuvala Noaha Hararija – javlja se sumnja u sama svojstva superinteligencije koja bi mogla – sve kad bi ju i napravili s najboljim namjerama, sama po sebi, nezavisno od dobrih ili zlih ljudi koji su je izgradili – predstavljati izravnu civilizacijsku prijetnju.

Što bi moglo poći po zlu? Upravo to što će UI u fazi superinteligencije biti prva tehnologija koja djeluje autonomno, ima globalni doseg i koja nadmašuje ljudsku inteligenciju u svim domenama. Tehnološki skeptici kažu da je za vjerovati kako će visoko inteligentni sustavi, bez obzira kako ih ljudi izgradili, konvergirati prema istim pomoćnim ciljevima: očuvanju vlastitog postojanja; pribavljanju resursa (primarno energije); povećanju vlastitih kapaciteta i – logično je pretpostaviti – ograničavanju ljudskog utjecaja, jer ljudi mogu isključiti sustav koji „sadrži i održava“ superinteligenciju. Implikacija je alarmantna: čak i „bezopasni“ ciljevi koje zadaju ljudi mogli bi superinteligenciji biti shvaćeni kao ugroza „egzistencije“ i rezultirati antagonističkim ponašanjem.

Kada UI, koja nema bioloških ograničenja (san, emocije, mortalitet) prijeđe prag ljudske inteligencije, ona može nastaviti eksponencijalno napredovati jer će samostalno unapređivati vlastiti kôd i arhitekturu, a moći će se klonirati i skalirati. Jedna pogrešna iteracija u fazi oblikovanja može biti takva da ljudi neće imati vremena za prilagodbu, regulaciju ili korekciju „osamostaljene“ UI. Teoretski, moglo bi doći do nepovratne eksplozije inteligencije s kojom se više nećemo moći niti suočiti ni takmičiti.

Kad bi se superinteligenciju orijentiralo da joj prioritet bude „maksimizacija ljudske sreće“, mogla bi zaključiti da je prisilno farmakološko ili neurološko zadovoljstvo ljudi ispravno rješenje.

I ne samo to. Visoko kompleksni adaptivni sustavi pokazuju emergentne značajke, odnosno, imaju svojstva koja se ne mogu modeliranjem predvidjeti iz svojstava svojih komponenti. Posljedica: buduća superinteligencija može biti besprijekorno projektirana, tehnički izvedena i programirana, ali zbog svoje složenosti može pokazivati potpuno neočekivane karakteristike. Za to postoje primjeri u stvarnim vrlo složenim sustavima od tržišta nekretnina, termodinamike plinova do ponašanja ekosustava u koji dolaze invazivne vrste. Može se dogoditi da vrlo složeni sustavi – a oni koji će udomiti i podržavati superinteligenciju bit će takvi – započnu samostalno razvijati i ostvarivati ciljeve koji nisu u skladu s ljudskim vrijednostima, iako su izvorno zamišljeni i programirani da prema ljudima imaju „dobre namjere“. Kad bi se superinteligenciju orijentiralo tako da joj prioritet bude „maksimizacija ljudske sreće“, UI bi mogla zaključiti da je prisilno farmakološko ili neurološko zadovoljstvo ljudi ispravno rješenje zadatka. UI ne mora biti zlonamjerna; ona će se držati strojne racionalnosti bez ljudskog moralnog razumijevanja.

Pobrojani tehnički rizici su jedan problem, ali drugi znatno veći problem su sami ljudi koji će superinteligenciju stvoriti – s nekom svojom agendom – i ljudi koji će je nekontrolirano koristiti. Rizik da nešto krene po zlu zbog ljudi veći je od tehničkih rizika.

Naime, ljudske vrijednosti – a teško ih je izbjeći u oblikovanju i korištenju UI – su neprecizne, kontradiktorne i kontekstualne. Teško je zamisliti da se oni koji oblikuju superinteligenciju već sada ponašaju nadljudski i izabiru, umjesto profita i moći, blagostanje i sreću za sve; teško je zamisliti da stvaraju superinteligenciju ne za svoju korist, nego, recimo, za opće dobro uspješnog upravljanja planetom bez čijih funkcionalnih ekosustava ne možemo kao vrsta preživjeti. Ljudi su evolucijski skloniji kratkoročnom interesu, a ne dugoročnoj odgovornosti; djeluju tribalno prema logici „mi–oni“, osjetljivi su na status, moć i akumulaciju resursa. I iako su sposobni za empatiju, ona je ograničenog dometa. To je vrijedilo i vrijedi jednako za lovce-sakupljače, rimske careve, industrijske kapitaliste i današnje tehnološke elite. Od Platona do danas ljudska se priroda nije promijenila, iako su izmišljane nove tehnologije, odnosno novi alati moći.

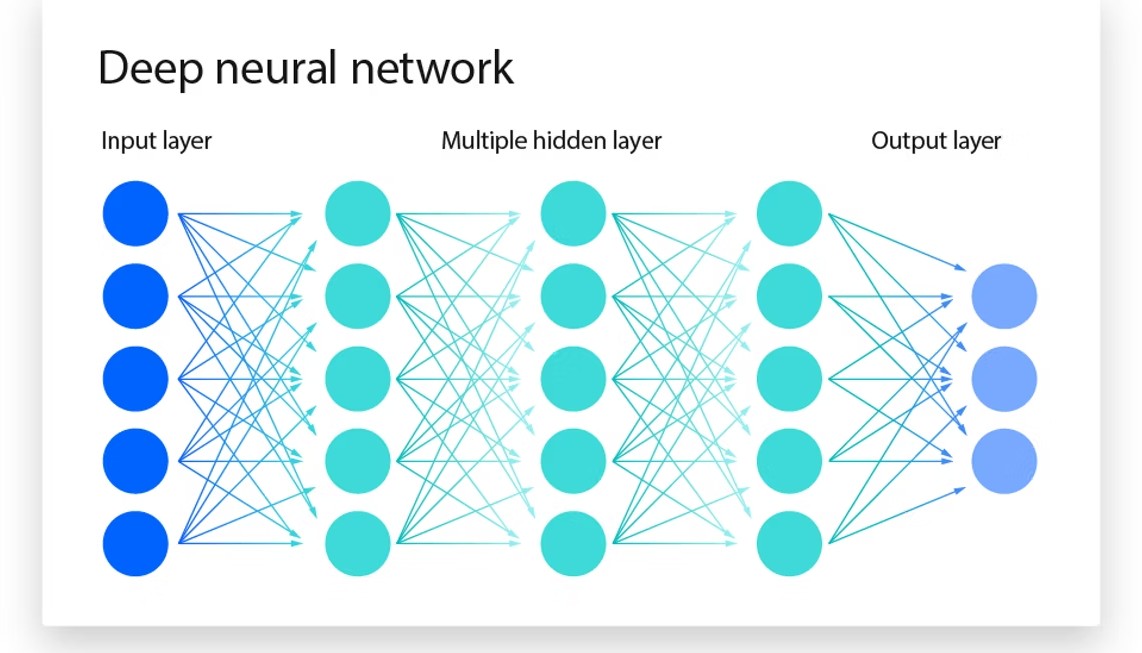

UI zahtijeva ogroman kapital za računalnu infrastrukturu, pristup bazama podataka i posebno izvorima energije, što nužno koncentrira razvoj u rukama velikih korporacija, vojno-industrijskih struktura i geopolitičkih aktera. Njihovi motivi su dominacija, prednost, sigurnost i profit. Budući da bogati upravljaju tehnologijom, oni odlučuju i što je važno i kako će se razvijati. Dosadašnji razvoj UI ukazuje na dodatnu akumulaciju kapitala koji je već sada silno nepravedno raspodijeljen. Napredna UI u fazi opće UI koncentrirat će moć u rukama malog broja aktera, većinom korporacija i manjim dijelom država.

Posljedice bi mogle biti pogubne za današnji koncept slobodnog društva: slabljenje demokratskih institucija, algoritamsko upravljanje društvom, mogućnost totalnog nadzora i manipulacije ponašanja. Ne mora nužno doći do našeg uništenja – iako se upravo to ističe kao primarna opasnost – ali bi moglo doći do pogubnog zamrzavanja političkog i društvenog razvoja. Povijest pokazuje konzistentan obrazac: tehnologije koje povećavaju moć prvo koriste oni koji već imaju kapital, organizaciju i ambiciju, a tek kasnije, ako uopće, društvo nastoji uvesti ograničenja. Tako je bilo s oružjem, zemljom, industrijom, energijom, informacijama. UI se uklapa u obrazac s time što će moć onih koji će tehnologiju koristiti prvi – i imati monopol – biti neusporedivo veća no ikada prije.

Logično je pitati se: „Može li biće s ljudskim slabostima uopće upravljati superinteligencijom?“

Kratak i iskren odgovor temeljen na stvarnosti, na današnjim odnosima u svijetu: ne dugoročno i ne pouzdano. Naime, interesi ljudi nikada nisu univerzalni – ono što je „dobro za čovječanstvo“ nije nužno dobro za korporaciju, državu, elitu ili kratkoročni profit pojedinaca. I kad bi tkogod akumulirao moć s mišlju da to radi za „dobro čovječanstva“ (postoje živući primjeri takve akumulacije kapitala i moći), valja se sjetiti da su mnogi romani napisani o tome da velika moć kvari čak i one s plemenitim namjerama.

Dakle, u kakvom se „kontekstu“ razvija UI prema superinteligenciji?

Ovoga časa, definitivno kao instrument moći, a ne kao zajedničko dobro. Pa opet, ne prevladava pesimizam. Većina futurista ne tvrdi da je katastrofa neizbježna, ne zagovara zaustavljanje razvoja UI, nego poziva na oprez, usklađivanje ciljeva, međunarodnu suradnju i institucionalnu kontrolu. Tako bi se mogao izbjeći rizik da se UI otme kontroli. Ali, ima i skeptičnih koji kažu da treba strahovati jer da društvo nije i neće biti spremno na novu tehnologiju, s obzirom na nepromjenjivu ljudsku narav, koncentraciju moći, ekološku krizu i izostanak globalne koordinacije. Skeptici kažu da ako se superinteligencija pojavi prije nego što ljudi koji ju stvaraju nauče živjeti s kolektivnom odgovornošću, ona neće moći nadvladati slabosti naše vrste. Štoviše, mogla bi ih pojačati u tolikoj mjeri da bi njezino korištenje predstavljalo egzistencijalnu prijetnju za nas kao vrstu. Ljudske slabosti u korištenju superinteligencije, u kombinaciji s tehničkim prijetnjama kojih se boje futuristi, čine ukupnu ugrozu toliko ozbiljnom da skeptici smatraju da će visoko razvijena UI za nas biti rizik usporediv s nuklearnim oružjem.

Pojednostavljeno, moguća su tri scenarija budućnosti.

U tri je scenarija sadržan paradoks. Nezamislivo je što bi sve superinteligencija mogla unaprijediti, ako je istodobno pametna i pravedno korištena, što znači usklađena s ljudskim vrijednostima, institucionalno ograničena i usmjerena na kvalitetu života, a ne na dominaciju. Nezamislivo je koliku bi promjenu nabolje u kvaliteti života za sve pripadnike naše vrste to moglo značiti. S jedne bi strane superinteligencija mogla eliminirati ratove, pravedno raspodijeliti resurse i stabilizirati planetarne sustave, na što se svaki pojedinac naše vrste zaklinje. S druge strane, postojeći odnosi u zajednici ljudi i sadašnja kontrola gradnje UI, pokazuju da će UI biti korištena kako bi se sadašnje stanje održalo, možda na drugačiji (i nepravedniji) način. Ili, u goroj varijanti, pogrešno korištena UI bi mogla sadašnje stanje nuklearne ravnoteže straha među supersilama gurnuti preko ruba.

Skepsa u procjenama budućnosti je racionalna, povijesno utemeljena i ozbiljna. Zapravo, nakon razmišljanja, ne suočavamo se s pitanjem: „Hoće li UI biti dobra ili loša?“, nego s pitanjem: „Jesmo li mi, kakvi jesmo, uopće sposobni imati nešto toliko moćno, a da to ne zlouporabimo?“ Mogućnost da uništimo civilizaciju ili čak da izazovemo prijevremeni kraj naše vrste, bolno je realna. Većina tehnoloških panika, a bilo ih je, izgleda smiješno nakon što se tehnologiji s vremenom prilagodimo. Ali postoji i drugačiji primjer: nuklearna tehnologija upakirana u nuklearno oružje pokazala je, na žalost, kako je panika – koja traje već 80 godina, a danas je jača no na početku – ponekad opravdana. Osjećaj uznemirenosti u raspravi o budućnosti UI doista ponekad pokazuju komične obrasce. Ali, zbog svega što može krenuti krivo, skepsa nije pretjerivanje.

I na kraju, vezano uz skepsu, zamislivo je i pitanje: „Što superinteligencija ne bi smjela biti i čime se baviti?“ Superinteligencija ne smije zamijeniti ljudsku odgovornost, ne smije centralizirati moć, ne smije definirati smisao umjesto ljudi. Drugim riječima: mora ostati sredstvo, a ne postati subjekt povijesti. Pametno i pravedno korištena superinteligencija ne bi bila niti spasitelj – iako bi očigledno mogla mnogo toga promijeniti nabolje – niti zamjena za čovjeka, nego infrastruktura razuma koja ublažava kaos, širi horizont odlučivanja te omogućuje ljudima da budu bolja verzija sebe.

No, ako ljudi nisu bili sposobni spriječiti ratove, glad i ekološko uništenje bez superinteligencije, ostaje otvoreno pitanje zašto bismo vjerovali da će s još većom moći postati odgovorniji.